Kluczowe fakty (przeczytaj najpierw)

- Nastroje społeczne: W najnowszym badaniu Pew Research Center (17 września 2025 r.) więcej Amerykanów deklaruje niepokój niż ekscytację z powodu rozprzestrzeniania się AI—szczególnie w kontekście deepfake’ów, utraty miejsc pracy i utraty kontroli.

- Zagrożone (lub zmienione) miejsca pracy: MFW szacuje, że ~40% globalnego zatrudnienia jest narażone na AI; w gospodarkach rozwiniętych ekspozycja wzrasta do ~60%. Skutki obejmują zarówno wsparcie, jak i zastępowanie ludzi.

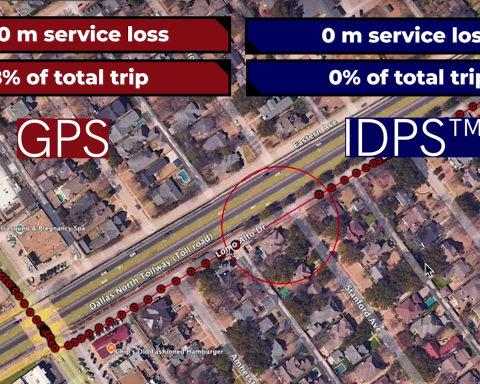

- Ryzyka cybernetyczne i wyborcze: OpenAI i Microsoft ujawniły operacje powiązane z Rosją, Chinami, Iranem i Koreą Północną, które eksperymentują z generatywną AI w celach wpływu i cyberprzestępczości; doszło do likwidacji części działań, ale możliwości tych państw rosną.

- Prawa autorskie i twórcy: Spory prawne o dane treningowe zaostrzyły się (NYT kontra OpenAI/Microsoft; pozwy wielu autorów). Anthropic osiągnął porozumienie ramowe z autorami książek w 2025 r., co zapowiada kosztowne kompromisy w przyszłości.

- Deepfake’i dotykają prawdziwych ludzi: Robocall z głosem Bidena był wymierzony w wyborców z New Hampshire w styczniu 2024 r.; FTC wielokrotnie ostrzegała rodziny przed oszustwami z klonowaniem głosu AI.

- Regulacje nadrabiają zaległości: Akt o AI UE wszedł w życie w 2024 r. (wdrażany etapami), ONZ przyjęła pierwszą globalną rezolucję dotyczącą AI w 2024 r., a Deklaracja z Bletchley w Wielkiej Brytanii (listopad 2023) ustanowiła wspólny język ryzyka. USA mają prezydenckie rozporządzenie ws. AI (30 października 2023 r.) i zmieniające się podejście federalne w 2025 r.

- Ostrożność w ochronie zdrowia: WHO (2024/2025) i AMA (2024) wydały wytyczne: ostrożnie korzystać z LLM, zarządzać uprzedzeniami i zachować nadzór ludzki.

- Eksperci podzieleni w sprawie „x‑risk”: Tysiące badaczy AI ankietowanych w 2024 r. wskazało mediana ~5% szans, że AI może doprowadzić do wyginięcia ludzkości; opinie są bardzo zróżnicowane.

Kto się boi—i dlaczego

1) Pionierzy AI i badacze bezpieczeństwa

- Geoffrey Hinton („ojciec chrzestny AI”): „Istnieje szansa, że maszyny przejmą kontrolę.”

- Yoshua Bengio (laureat Nagrody Turinga) o deepfake’ach i kradzieży tożsamości: „Musimy absolutnie zakazać podrabiania ludzkich tożsamości.”

- Sam Altman (OpenAI) przed Senatem USA: „Jeśli ta technologia się nie powiedzie, może być naprawdę źle.”

Dlaczego się martwią: szybkie skoki możliwości, nadużycia (bio/cyber) oraz nierozwiązany problem niezawodnego dostosowania bardzo potężnych systemów do ludzkich wartości. W badaniu z 2024 r. wśród tysięcy autorów AI, 37,8–51,4% przypisuje co najmniej 10% szans na scenariusze „tak złe jak wyginięcie ludzkości”, co podkreśla realną niepewność nawet wśród optymistów.

2) Budowniczowie i kadra zarządzająca: ostrożność kontra kontrarianizm

- Dario Amodei (Anthropic): ostrzegał w 2025 roku, że AI może wyeliminować nawet połowę stanowisk pracy na poziomie podstawowym w sektorze białych kołnierzyków w ciągu ~5 lat; ocenia ~25% szans na to, że wszystko skończy się „naprawdę, naprawdę źle”.

- Yann LeCun (Meta): „AI przyniesie wiele korzyści… [ale] ryzykujemy, że przestraszymy ludzi i zniechęcimy ich do niej.” Obawy o egzystencjalne ryzyko nazywa przedwczesnymi.

Dlaczego są podzieleni: krótkoterminowe korzyści (produktywność, nauka) kontra trudne do oszacowania ryzyka najgorszego scenariusza i realne efekty zewnętrzne (stronniczość, własność intelektualna, bezpieczeństwo). Badania pokazują znaczące wzrosty produktywności—np. 14–25% dla niektórych zadań—szczególnie u mniej doświadczonych pracowników, obok nowych typów błędów i nadmiernego polegania na AI.

3) Pracownicy, związki zawodowe i twórcy

- MFW: AI naraża ~40% miejsc pracy na świecie; proporcja między wspomaganiem a automatyzacją prawdopodobnie pogłębi nierówności bez odpowiedniej polityki.

- Autorzy/Redakcje: Pozew NYT i fala pozwów autorów argumentują, że szkolenie AI wykorzystywało chronione prawem autorskim dzieła bez zgody; w 2025 roku Anthropic zawarł proponowaną ugodę, co sugeruje, że licencjonowanie stanie się normą.

- Artyści i obrońcy praw obywatelskich: Joy Buolamwini (Algorithmic Justice League) ostrzega przed „zakodowanym spojrzeniem”—stronniczością zakorzenioną w systemach AI, które błędnie rozpoznają lub źle traktują grupy marginalizowane.

4) Wyborcy i strażnicy platform

Robocall z „głosem Bidena” w New Hampshire pokazał, jak tanio AI może podszywać się pod liderów; regulatorzy odpowiedzieli groźbami egzekwowania prawa, a platformy zaktualizowały polityki po publicznym oburzeniu innymi głośnymi deepfake’ami. FTC wydała proste wytyczne dla rodzin dotyczące oszustw z klonowaniem głosu.

5) Lekarze, pacjenci i urzędnicy zdrowia publicznego

- WHO (2024/2025) i AMA (2024) podkreślają potrzebę zabezpieczeń, przejrzystości i nadzoru człowieka nad LMM w ochronie zdrowia; wskazują na ryzyka związane z stronniczością, bezpieczeństwem i odpowiedzialnością.

- Badania i raporty wskazały na rasowe uprzedzenia w odpowiedziach medycznych chatbotów, co wzmacnia ostrożność przy ich klinicznym zastosowaniu.

6) Obrońcy cyberbezpieczeństwa i zespoły ds. bezpieczeństwa wyborów

- OpenAI + Microsoft ujawnili pięciu aktorów powiązanych z państwami, eksperymentujących z LLM (np. do phishingu, operacji informacyjnych). Wczesne działania miały ograniczony zasięg, ale obrońcy spodziewają się szybkich cykli uczenia się.

7) Obrońcy środowiska i praw pracowniczych

- Kate Crawford (Atlas of AI): „AI nie jest ani sztuczna, ani inteligentna.” Twierdzi, że branża jest eksploatacyjna (minerały, energia, dane, ludzkie oznaczanie), co budzi obawy wykraczające poza same „bity”.

Co robią rządy (i dlaczego to ma znaczenie)

- Unia Europejska: Akt o AI UE (OJ L, lipiec 2024) wprowadza reżim oparty na poziomach ryzyka (zakazy, obowiązki dla wysokiego ryzyka, przejrzystość). Wdrażanie potrwa do 2025–2026, a Biuro AI będzie koordynować egzekwowanie przepisów. Spodziewaj się dużej pracy nad zgodnością dla zastosowań „wysokiego ryzyka” i obowiązków ujawniania dla systemów generatywnych.

- Organizacja Narodów Zjednoczonych: W marcu 2024 Zgromadzenie Ogólne jednogłośnie przyjęło pierwszą globalną rezolucję dotyczącą AI w sprawie bezpiecznej, pewnej i godnej zaufania AI — niewiążącą, ale stanowiącą silny sygnał norm.

- Wielka Brytania i partnerzy: Deklaracja z Bletchley (listopad 2023) dała światu wspólne słownictwo dotyczące ryzyk „frontier AI”; kolejne szczyty (Seul 2024; raport w 2025) utrzymały testy bezpieczeństwa i ewaluacje w agendzie.

- Stany Zjednoczone: Zarządzenie wykonawcze 14110 (30 października 2023) nakazało agencjom federalnym działania w zakresie bezpieczeństwa AI, testów red-teamingowych i ochrony praw obywatelskich; sygnały polityczne na 2025 odzwierciedlają debatę między przyspieszeniem innowacji a nowymi regulacjami.

Podsumowanie: Regulatorzy skupiają się mniej na „apokalipsie science-fiction”, a bardziej na konkretnych szkodach: dyskryminacji, dezinformacji, krytycznych awariach bezpieczeństwa, prywatności i sile rynkowej. To tam widzą najbliższe zagrożenia — i odpowiedzialność prawną.

Gdzie eksperci faktycznie się nie zgadzają

- Ryzyko ogonowe vs. namacalne szkody:

- Grupa ostrzegająca przed ryzykiem egzystencjalnym wskazuje na niezerowe prawdopodobieństwo katastrofalnej porażki z powodu niezgodnych systemów lub umożliwienia powstania bio/cyber super-zagrożeń (patrz oświadczenie CAIS: „Ograniczanie ryzyka wyginięcia z powodu AI powinno być globalnym priorytetem.”).

- „Normaliści” (np. Yann LeCun) twierdzą, że obecne modele są dalekie od poziomu ludzkiego; panika odwraca uwagę od realnej pracy nad bezpieczeństwem i innowacjami.

- Open-source vs. licencjonowanie modeli „frontier”:

Zwolennicy licencjonowania twierdzą, że potrzebujemy kontroli bezpieczeństwa przed wdrożeniem; zwolennicy open-source obawiają się centralizacji i wolniejszego usuwania błędów. (Patrz zmieniające się ustawy stanowe Kalifornii dotyczące przejrzystości frontier). - Wpływ na pracę:

MFW wskazuje na ryzyko makroekonomiczne; niektórzy CEO (np. Amodei, Jim Farley) przewidują duże redukcje wśród pracowników umysłowych; inni oczekują zmiany zadań i nowych ról. Dotychczasowe dowody: wzrost wydajności przy nierównych efektach jakościowych i nowych trybach awarii.

Czego najbardziej obawiają się różne społeczności (głos ekspertów)

- Obrońcy praw obywatelskich: Stronniczość i narastający nadzór. Buolamwini ukuła termin „zakodowane spojrzenie”, aby opisać zakorzenione uprzedzenia w AI; regulatorzy tacy jak EEOC ostrzegają przed algorytmiczną dyskryminacją w rekrutacji.

- Liderzy ochrony zdrowia: Bezpieczeństwo pacjentów, odpowiedzialność i równość. WHO i AMA naciskają na zarządzanie, testowanie i przejrzystość przed klinicznym zastosowaniem.

- Urzędnicy ds. cyberbezpieczeństwa/wyborów: Skalowalne oszustwa. Microsoft/OpenAI opisują eksperymenty państw narodowych; obrońcy spodziewają się więcej operacji wpływu wspomaganych przez AI.

- Twórcy i wydawcy: Nieopłacone szkolenie, substytucja rynkowa i szkody reputacyjne. (Zobacz NYT v. OpenAI/Microsoft; ugody z autorami.)

- Liderzy globalni: Luki w zarządzaniu. Na Davos 2024, Sekretarz Generalny ONZ António Guterres ostrzegł przed „zagrożeniem egzystencjalnym” wynikającym z *„niekontrolowanego rozwoju… bez zabezpieczeń.”

Nie każdy strach jest uzasadniony

- „AI jest już nadludzka.” Dzisiejsze wiodące systemy wciąż zawodzą w rozumowaniu, faktach i osadzeniu w rzeczywistości. Gary Marcus twierdzi, że LLM są „fundamentalnie zawodne” bez bardziej solidnej architektury.

- „Wszystkie prace znikną.” Wysokiej jakości badania pokazują duże zyski na poziomie zadań—szczególnie dla mniej doświadczonych pracowników—sugerując wspomaganie i wyrównywanie umiejętności w najbliższym czasie (przy realnych zakłóceniach na poziomie wejściowym).

Co się robi — i co możesz zrobić

Firmy:

- Stwórz rejestr ryzyka AI powiązany z NIST AI Risk Management Framework; wymagaj testów red-teamingowych i dowodów oceny modeli przed wdrożeniem.

- Oznaczaj media syntetyczne wewnętrznie; wdrażaj technologie pochodzenia; szkol personel w rozpoznawaniu prompt‑injection, halucynacji i zagrożeń deepfake. (FTC ma praktyczne wskazówki dotyczące klonowania głosu dla rodzin.)

- Zarządzanie danymi i własność intelektualna: Śledź dane treningowe, licencjonowanie i rezygnacje; uważnie obserwuj zmieniające się orzecznictwo dotyczące praw autorskich (i ugody).

Rządy i instytucje:

- Wprowadź zasady oparte na poziomach ryzyka (w stylu UE) oraz oceny wpływu; wykorzystaj zamówienia publiczne, aby wymagać przejrzystości i oświadczeń o bezpiecznym użytkowaniu.

- Finansuj niezależne ewaluacje i benchmarki bezpieczeństwa; dostosuj się do współpracy ONZ/Bletchley, aby ograniczyć nadużycia transgraniczne.

Osoby indywidualne:

- Traktuj wyniki AI jak pierwsze szkice; weryfikuj fakty.

- Bądź sceptyczny wobec pilnych wiadomości głosowych (możliwe klony); potwierdź przez drugi kanał.

- Dowiedz się, jak narzędzia w twoim miejscu pracy wykorzystują dane; rezygnuj z tego, gdzie to możliwe.

Krótki przegląd cytatów ekspertów (różne perspektywy)

- Hinton: „Istnieje szansa, że maszyny mogą przejąć kontrolę.”

- Bengio: „Zdecydowanie musimy zakazać fałszowania ludzkich tożsamości.”

- Altman: „Jeśli ta technologia zawiedzie, może zawieść bardzo poważnie.”

- LeCun: „AI przyniesie wiele korzyści… [ale] ryzykujemy, że przestraszymy ludzi.”

- Kate Crawford: „AI nie jest ani sztuczna, ani inteligentna.”

- Joy Buolamwini: „Zakodowane spojrzenie” (jej określenie) oddaje uprzedzenia zakorzenione w AI.

- WHO (wytyczne): Nadzór ludzki i zarządzanie ryzykiem są niezbędne dla LMM w zdrowiu.

- Oświadczenie CAIS (2023): „Ograniczenie ryzyka wyginięcia z powodu AI powinno być globalnym priorytetem.”

FAQ

Czy strach dotyczy głównie scenariuszy z „Terminatora”?

Nie. Decydenci podkreślają obecne szkody (oszustwa, uprzedzenia, bezpieczeństwo), podczas gdy badacze debatują nad ryzykiem o niskim prawdopodobieństwie, ale wysokim wpływie. Środki ONZ i UE odzwierciedlają to podwójne podejście.

Czy miejsca pracy są skazane na zagładę?

Dowody wskazują na wspomaganie i wzrost jakości obecnie, przy poważnym ryzyku wyparcia na stanowiskach początkowych w białych kołnierzykach, jeśli wdrożenie będzie szybkie i bez zabezpieczeń. Polityka i decyzje firm będą miały kluczowy wpływ na rezultaty.

Dlaczego twórcy są tak zaniepokojeni?

Ponieważ status prawny trenowania na chronionych prawem autorskim materiałach jest niejasny, a nadużycia deepfake gwałtownie rosną; sądy i ugody zaczynają wyznaczać granice.

Wnioski

- Kto się boi? Wiele osób—z różnych powodów: obywatele (oszustwa/deepfakes), pracownicy (utrata pracy), lekarze (bezpieczeństwo), organizacje praw obywatelskich (stronniczość/nadzór), zespoły ds. bezpieczeństwa (operacje cybernetyczne), twórcy (własność intelektualna), i tak, niektórzy pionierzy AI (ryzyko ogonowe).

- Co jest racjonalne? Skoncentruj swoją energię na kontrolach wobec realnych, obecnych szkód, jednocześnie nalegając na poważną ocenę systemów z czołówki rozwoju.

- Co dalej? Obserwuj wdrażanie w UE, stanowienie prawa federalnego/stanowego w USA, ugody dotyczące praw autorskich oraz to, czy cyberoperacje wspierane przez AI przejdą z „eksperymentów” do istotnego wpływu w latach 2025–2026.

Źródła i dalsza lektura

Pew Research Center; MFW; CBS/60 Minutes; C‑SPAN; Wired; Dziennik Urzędowy UE; AP/Reuters; Rząd Wielkiej Brytanii (Bletchley); WHO/AMA; raporty o zagrożeniach OpenAI & Microsoft; FTC. (Zobacz cytowania w całym tekście.)