- Czym jest: Neuromorficzne (czyli inspirowane mózgiem) obliczenia przestawiają układy scalone tak, aby pamięć znajdowała się wraz z jednostką obliczeniową, co radykalnie ogranicza przemieszczanie danych – główne źródło zużycia energii we współczesnej AI. IBM nazywa to projektem „in‑/near‑memory” i jest to podstawa jego układów badawczych NorthPole oraz analogowego „Hermes”. IBM Research

- Dlaczego teraz: Zapotrzebowanie AI na energię elektryczną gwałtownie rośnie. IEA przewiduje, że globalne zużycie energii przez centra danych mniej więcej się podwoi do 2030 roku – a głównym motorem będzie AI – co stawia efektywność na pierwszym planie. IEA

- Kto prowadzi: IBM NorthPole osiąga rekordową szybkość/efektywność wnioskowania dzięki ścisłemu połączeniu pamięci i obliczeń; Intel Hala Point łączy 1 152 układów Loihi 2 w największy na świecie system neuromorficzny do badań w Sandia. IBM Research

- Od edge do chmury: Kamery zdarzeniowe Sony/Prophesee przesyłają tylko „zmiany”, umożliwiając ultraniskie zużycie energii i niskie opóźnienia na brzegu sieci; projekty near‑memory, takie jak NorthPole, rozwiązują wąskie gardła wnioskowania w centrach danych. Sony Semiconductor

- Co nie zostało rozwiązane: Trening bezpośrednio na sprzęcie analogowym/memrystorowym wciąż się rozwija; narzędzia i benchmarki są rozproszone – choć pojawia się nowy, społecznościowy standard NeuroBench. Nature

- Prognoza na 2026: Spodziewaj się większej liczby pilotażowych wdrożeń w percepcji zdarzeniowej, robotyce i „urządzeniach AI” do wnioskowania LLM; dostęp do ekosystemu rozszerza się dzięki europejskim platformom EBRAINS (BrainScaleS, SpiNNaker). ebrains.eu

Czym są neuromorficzne (inspirowane mózgiem) obliczenia?

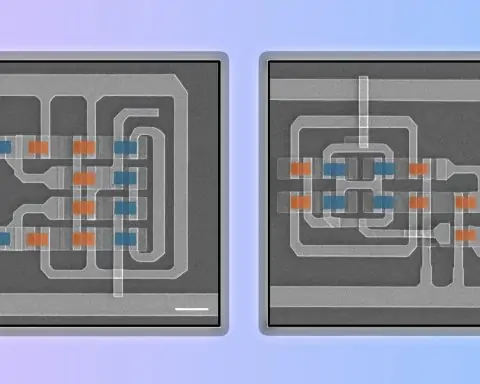

Neuromorficzne obliczenia czerpią z zasad działania mózgu: współlokalizują pamięć i obliczenia, aby uniknąć „korków” von Neumanna, czyli przesyłania danych między oddzielnymi układami. IBM opisuje tę zmianę jako in‑memory (analogowe matryce krzyżowe, które jednocześnie przechowują i przetwarzają) lub near‑memory (cyfrowe rdzenie otoczone szybką pamięcią na chipie). „Obliczenia in‑memory minimalizują lub redukują do zera fizyczne oddzielenie pamięci od obliczeń” – mówi Valeria Bragaglia z IBM Research. IBM Research

Ta zmiana architektury ma znaczenie, ponieważ większość pracy AI to ogromne mnożenia macierzy—prosta matematyka wykonywana biliony razy. Gdy wagi znajdują się na chipie obok jednostki obliczeniowej, opóźnienia i zużycie energii gwałtownie spadają. Przegląd IBM wyjaśnia, jak zarówno analogowy układ Hermes (krzyżowe pamięci zmiany fazy), jak i cyfrowy prototyp NorthPole wykorzystują tę zasadę, by pokonać barierę pamięci. IBM Research

Dlaczego teraz: krzywa zużycia energii przez AI jest nie do utrzymania

Wzrost AI zderza się z realiami energetycznymi. Międzynarodowa Agencja Energetyczna przewiduje obecnie, że zapotrzebowanie centrów danych na energię ponad dwukrotnie wzrośnie do 2030 roku, osiągając około 945 TWh, a głównym czynnikiem przyspieszającym będzie AI. Dlatego architektury, które ograniczają przemieszczanie danych—a nie tylko zwiększają FLOPs—są w centrum uwagi. IEA

Neuromorficzny lider Intela Mike Davies ujmuje to dosadnie: “Koszt obliczeniowy dzisiejszych modeli AI rośnie w tempie nie do utrzymania.” Jego zespół zbudował Hala Point, klaster 6U z 1 152 procesorami Loihi 2 (≈1,15 mld neuronów, 128 mld synaps), aby badać bardziej zrównoważoną, zdarzeniową AI w Sandia National Labs. Intel Corporation

Stan gry: kluczowe platformy, które warto znać

- IBM NorthPole (cyfrowy, blisko pamięci): W nowych testach na LLM z 3 miliardami parametrów, 16-kartowy serwer NorthPole osiągnął <1 ms/token i 46,9× niższe opóźnienie niż kolejny najbardziej energooszczędny GPU, będąc jednocześnie 72,7× bardziej energooszczędnym niż GPU o najniższym opóźnieniu. Wcześniej NorthPole był 25× bardziej energooszczędny niż powszechnie używane 12-nm GPU w zadaniach wizji komputerowej. IBM Research

Kontekst: Perspektywa Nature Communications z 2025 roku klasyfikuje NorthPole jako „wydajny procesor rzadkich tensorów blisko pamięci”, a nie SNN czy analogowe urządzenie compute-in-memory—podkreślając, że „neuromorficzny” obejmuje kilka stylów sprzętowych. Nature - Intel Loihi 2 / Hala Point (cyfrowy, impulsowy): Hala Point łączy 140 544 neuromorficzne rdzenie w system 1,15 mld neuronów o wydajności do 15 TOPS/W na konwencjonalnych DNN, zaprojektowany do pracy w czasie rzeczywistym i badań nad ciągłym uczeniem. Intel Corporation

- Wizja oparta na zdarzeniach (edge): Sony i Prophesee współtworzyli układ warstwowych sensorów, które przekazują tylko zmiany pikseli z mikrosekundowym opóźnieniem i bardzo niskim poborem mocy—idealne dla robotyki, AR i urządzeń „zawsze włączonych”. Prophesee opisuje asynchroniczny, rzadki przepływ danych, który odzwierciedla przetwarzanie siatkówki. Sony Semiconductor

- Dostęp do EBRAINS (Europa): Naukowcy i startupy mogą zdalnie uruchamiać sieci impulsowe na BrainScaleS (analogowe/mieszane sygnały, do 10 000× szybciej niż w czasie rzeczywistym) oraz SpiNNaker (cyfrowy, wielordzeniowy ARM). Europejski projekt Human Brain Project zakończył się w 2023 roku, ale EBRAINS utrzymuje platformy neuromorficzne online. ebrains.eu

Jak to działa (bez żargonu)

- Cyfrowe blisko pamięci (np. NorthPole): Trzymaj wagi na chipie obok jednostki obliczeniowej; planuj dane tak, by prawie nic nie opuszczało układu. Efekt: duże zyski w opóźnieniach i zużyciu energii podczas wnioskowania, w tym LLM w umiarkowanej skali. IBM Research

- Impulsowe/oparte na zdarzeniach (np. Loihi): Neurony aktywują się tylko, gdy coś się zmienia; sieci pozostają w większości ciche. To naturalnie pasuje do kamer zdarzeniowych i pętli sterowania, gdzie opóźnienie i pobór mocy są najważniejsze. Intel Corporation

- Analogowe w pamięci (np. matryce PCM): Elementy rezystancyjne przechowują wagi i wykonują mnożenie-akumulację za pomocą fizyki (prawo Ohma). Świetne do wnioskowania; trening na chipie pozostaje aktywnym obszarem badań. IBM Research

Co mówią eksperci

„Obliczenia w pamięci minimalizują lub redukują do zera fizyczne oddzielenie pamięci od obliczeń.” — Valeria Bragaglia, IBM Research. IBM Research

„Chcemy uczyć się od mózgu… w sposób matematyczny, optymalizując pod kątem krzemu.” — Dharmendra Modha, IBM Fellow (NorthPole). IBM Research

„Koszt obliczeniowy dzisiejszych modeli AI rośnie w tempie nie do utrzymania.” — Mike Davies, Intel Labs (Loihi/Hala Point). Intel Corporation

Co jest gotowe już teraz—a co nie

Gotowe lub prawie gotowe

- Percepcja brzegowa tam, gdzie liczy się każdy miliwat: kamery zdarzeniowe + akceleratory impulsowe/blisko-pamięciowe do monitoringu przemysłowego, dronów i urządzeń noszonych. Sony Semiconductor

- Niskolatencyjne wnioskowanie „urządzenia” dla LLM ~1–3 mld parametrów, wykorzystujące projekty blisko-pamięciowe, które przesyłają warstwy przez karty zamiast obciążać zewnętrzną pamięć DRAM. IBM Research

- Otwartość platform: EBRAINS pozwala zespołom prototypować na BrainScaleS i SpiNNaker bez konieczności zakupu sprzętu. ebrains.eu

Wciąż dojrzewa

- Trenowanie na urządzeniu z użyciem macierzy analogowych: Precyzyjne programowanie wag (z dryfem/szumem) jest trudne; badania z lat 2024–2025 pokazują postęp algorytmiczny, ale nie szeroką gotowość produkcyjną. Nature

- Narzędzia i benchmarki: Fragmentacja oprogramowania utrudniała porównania między układami; NeuroBench (2025) to pierwsza szeroko wspierana próba stworzenia standardowych, sprzętowo-świadomych benchmarków. Nature

Weryfikacja rynkowa

Prognozy różnią się drastycznie, ponieważ definicje są różne (czujniki vs procesory; sprzęt badawczy vs komercyjny). MarketsandMarkets szacuje neuromorficzne obliczenia na 28,5 mln USD (2024) rosnące do 1,33 mld USD do 2030; Grand View Research obejmuje szerszy zakres i prognozuje 20,27 mld USD do 2030. Traktuj szacunki ostrożnie i obserwuj wdrożenia, nie tylko nagłówki. MarketsandMarkets

Perspektywa 12–24 miesięcy (nasz scenariusz bazowy)

- Najpierw edge: Spodziewaj się, że percepcja zdarzeniowa pojawi się w większej liczbie robotów, kamer QA w fabrykach i urządzeń zasilanych bateryjnie, gdzie rzadkie sygnały przekładają się bezpośrednio na żywotność baterii. Sony Semiconductor

- „Urządzenia” do wnioskowania dla korporacyjnych LLM: projekty blisko-pamięciowe (podobne do NorthPole) w formie kart PCIe/obudów 2U dla modeli poniżej 10 mld parametrów i agentowych przepływów pracy z rygorystycznymi SLA dotyczącymi opóźnień/energii. IBM Research

- Otwarta infrastruktura: EBRAINS nadal obniża bariery; duże laboratoria będą publikować więcej wyników Hala Point i SpiNNaker, które podkreślają uczenie i sterowanie w czasie rzeczywistym, online. Intel Corporation

- Oprogramowanie/standardy: Przyspiesza adopcja NeuroBench; można spodziewać się postępów w zakresie wspólnych IR oraz stosów przyjaznych Pythonowi, które sprawiają, że sprzęt neuromorficzny wydaje się „jak GPU” dla inżynierów ML. Nature

Ryzyka i niewiadome

- Uzależnienie od modelu programowania: Bez narzędzi klasy CUDA adopcja się zatrzymuje. Standardy (benchmarki, IR, API) są kluczowe. Nature

- Zmienność urządzeń analogowych: Dryf/szum/wytrzymałość muszą zostać opanowane, aby umożliwić trening na dużą skalę; obiecujące, ale nierozwiązane. Nature

- Hype kontra waty: Wyniki producentów się poprawiają, ale niezależne, na poziomie obciążenia pomiary—szczególnie dla LLM i agentów—zdecydują o zwycięzcach. (Raporty Nature i Science o NorthPole dostarczają wczesnego, zewnętrznego kontekstu.) Nature

Sedno sprawy

Obliczenia neuromorficzne to nie jeden układ—to rodzina projektów inspirowanych mózgiem, mających na celu ten sam problem: przenoszenie bitów to to, co zużywa waty. Ponieważ zużycie energii przez AI ma podwoić zużycie prądu przez centra danych w tej dekadzie, projekty, które trzymają wagi przy obliczeniach (i wykonują obliczenia tylko na istotnych zdarzeniach), wydają się gotowe do przejścia z demonstracji laboratoryjnych do ukierunkowanych, rzeczywistych systemów. Jak ujmuje to Modha z IBM, celem jest uczenie się od mózgu „w sposób matematyczny, optymalizując pod kątem krzemu.” Najpierw obserwuj edge vision—potem urządzenia do wnioskowania, które skracają opóźnienia i zużycie energii bez konieczności przepisywania całego stosu AI. IEA

Źródła i dalsza lektura

- Wyjaśnienie IBM Research na temat obliczeń neuromorficznych; cytaty i szczegóły architektury (NorthPole, Hermes). IBM Research

- Wyniki IBM NorthPole dla wnioskowania LLM i wcześniejszych benchmarków wizji. IBM Research

- Materiały prasowe Hala Point firmy Intel (specyfikacje, cytat Mike’a Daviesa); kontekst wdrożenia w Sandia. Intel Corporation

- Analiza IEA dotycząca zapotrzebowania na energię elektryczną przez centra danych i AI do 2030 roku. IEA

- Perspektywy Nature Communications: NorthPole jako procesor tensorowy blisko pamięci; ramy testowe NeuroBench. Nature

- Premiery i wyjaśnienie techniczne czujników zdarzeniowych Sony/Prophesee. Sony Semiconductor

- Dostęp EBRAINS do platform neuromorficznych BrainScaleS i SpiNNaker. ebrains.eu