- Włoski zespół ocenił ChatGPT na problemach z zakresu patologii w 10 podspecjalizacjach; tylko 32,1% odpowiedzi było wolnych od błędów—~68% zawierało przynajmniej jeden błąd. PubMed

- Cytowania bota były wątpliwe: z 214 referencji, 12,1% było niedokładnych a 17,8% było całkowicie zmyślonych („halucynacje”). PubMed

- Badanie, opublikowane w Virchows Archiv (European Journal of Pathology), uznało odpowiedzi za „przydatne” w 62,2% przypadków, ale nadal nieodpowiednie do rutynowej diagnostyki. PubMed

- Wyniki zostały nagłośnione przez włoskie i polskie media, które zwróciły uwagę na błędne diagnozy w przypadkach raka skóry i piersi oraz cytowały ostrzeżenie głównego autora, że „oko klinicysty pozostaje niezastąpione”. ANSA.it

- Inne recenzowane badania dają mieszany obraz: najlepsze chatboty mogą uzyskać ~66–72% na onkologicznych pytaniach wielokrotnego wyboru, ale tylko ~32–38% przy ocenie uzasadnień w formie swobodnego tekstu. JAMA Network

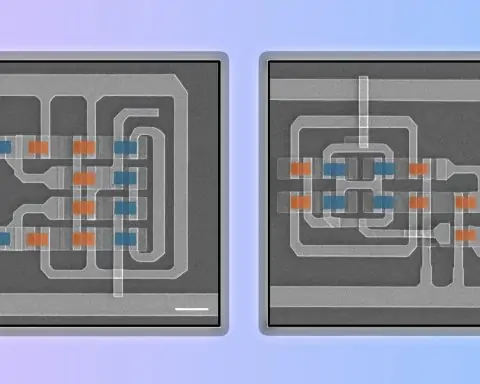

- Specjalistyczne medyczne LLM-y (np. Med‑PaLM 2 Google’a, AMIE) wykazują znaczne postępy i mogą poprawiać różnicowanie diagnoz przez klinicystów w warunkach kontrolowanych—ale nadal pozostają narzędziami badawczymi przed regulacją. Nature

- Regulatorzy zaostrzają zasady: unijna ustawa o AI weszła w życie 1 sierpnia 2024 (z etapowymi obowiązkami do 2026–2027), a amerykańska FDA wydała wytyczne dotyczące urządzeń AI/ML i zasady GMLP w 2025. U.S. Food and Drug Administration

Co tak naprawdę wykazało nowe badanie

Naukowcy z Humanitas University i Humanitas Research Hospital w Mediolanie przetestowali ChatGPT na kliniczno-patologicznych scenariuszach obejmujących dziesięć podspecjalizacji. Patolodzy oceniali wyniki pod kątem przydatności i błędów. Najważniejsze wyniki:

- Przydatne w 62,2% przypadków

- Bez błędów w 32,1% (czyli ~67,9% miało ≥1 błąd)

- Cytowania: 70,1% poprawnych, 12,1% niedokładnych, 17,8% nieistniejących

Artykuł podsumowuje, że pomimo pewnej użyteczności, zmienność wydajności i błędy „podkreślają [niewystarczalność ChatGPT] do rutynowego stosowania diagnostycznego” oraz uwypuklają „niezastąpioną rolę ludzkich ekspertów.” PubMed

Polski portal WirtualneMedia, podsumowując doniesienia włoskiej prasy, dodał przykłady błędnie zdiagnozowanego raka skóry i raka piersi, a także przekazał ostrzeżenie głównego autora, Vincenzo Guastafierro: „Oko klinicysty pozostaje niezastąpione. Sztuczna inteligencja powinna być wsparciem, a nie zamiennikiem.” Wirtualne Media

Ważna uwaga

Był to czatbot wyłącznie tekstowy oceniany pod kątem rozumowania patologicznego—niezatwierdzony przez FDA algorytm obrazowania ani regulowane narzędzie wspomagania decyzji klinicznych. Liczba „~70% błędnych” oznacza „zawiera przynajmniej jeden błąd”, a nie „całkowicie błędna diagnoza za każdym razem.” Zakres ma znaczenie. PubMed

Jak to wypada na tle innych najnowszych dowodów

- Wignietki onkologiczne (JAMA Network Open, 2024): W 79 przypadkach nowotworów najlepsze modele osiągnęły ~66–72% trafności w pytaniach wielokrotnego wyboru, ale trafność spadła do ~32–38%, gdy eksperci oceniali odpowiedzi otwarte—co pokazuje, jak format oceny wpływa na wyniki. JAMA Network

- Med‑PaLM 2 (Nature Medicine, 2025): Medyczny LLM dostrojony do dziedziny osiągnął 86,5% w pytaniach w stylu USMLE, a w pilotażu specjaliści czasami preferowali jego odpowiedzi na rzeczywiste zapytania—obiecujące, ale wciąż w warunkach badawczych. Nature

- AMIE (Nature, 2025): LLM zoptymalizowany pod kątem rozumowania diagnostycznego poprawił listy różnicowych rozpoznań klinicystów w randomizowanych porównaniach ze standardowymi narzędziami wyszukiwania (wyższa trafność top‑n, bardziej kompleksowe DDx). Nature

- Synteza dowodów (npj Digital Medicine, 2025): Pipeline o nazwie TrialMind zwiększył czułość i skrócił czas selekcji w przeglądach systematycznych, gdy był używany wspólnie z ludźmi, podkreślając wartość współpracy człowieka z AI, a nie zastępowania. Nature

Sedno sprawy: Wydajność znacznie się różni w zależności od zadania (wybór wielokrotny vs. odpowiedzi otwarte), dostrojenia (modele ogólne vs. medyczne) i sposobu użycia (samodzielny bot vs. lekarz w pętli). Wyniki zespołu z Mediolanu podkreślają ryzyka właśnie tam, gdzie błędy są najbardziej brzemienne w skutki—rozumowanie diagnostyczne. PubMed

Głosy ekspertów

- Vincenzo Guastafierro, MD (Humanitas): “Oko klinicysty pozostaje niezastąpione… AI powinna być wsparciem, a nie zamiennikiem.” (tłumaczenie) Wirtualne Media

- Jesse M. Ehrenfeld, MD, MPH (AMA): Aby AI w opiece zdrowotnej odniosła sukces, „lekarze i pacjenci muszą jej ufać… i musimy to zrobić dobrze.” American Medical Association

Dlaczego to ważne dla pacjentów i klinicystów

- Pacjenci: Chatboty mogą być przydatne w edukacji, ale nie powinny być używane do autodiagnozy. Proś o źródła i traktuj wyniki AI jako punkt wyjścia do rozmowy z lekarzem. American Medical Association

- Klinicyści: Traktuj ogólne LLM-y jak niesprawdzonego młodszego asystenta—przydatne do burzy mózgów lub pisania wstępnych wersji, ale wymagające weryfikacji z wytycznymi, dokumentacją i własnym osądem. PubMed

- Szpitale/systemy opieki zdrowotnej: Korzyści pojawiają się, gdy AI jest wbudowana w procesy z zabezpieczeniami—generowanie wspomagane wyszukiwaniem (by ograniczyć halucynacje), flagi niepewności, logi audytowe i nadzór ludzki. Nature

Kontekst regulacyjny (co się zmienia)

- Unia Europejska: Akt o AI UE wszedł w życie 1 sierpnia 2024. Zakazy dotyczące AI o „nieakceptowalnym ryzyku” obowiązują wcześniej; zasady dotyczące AI ogólnego przeznaczenia będą wdrażane około sierpnia 2025; obowiązki dotyczące wysokiego ryzyka (które obejmą wiele zastosowań medycznych) będą wdrażane w latach 2026–2027. Należy spodziewać się bardziej rygorystycznej dokumentacji, zarządzania ryzykiem i monitorowania po wprowadzeniu na rynek. Komisja Europejska

- Stany Zjednoczone: FDA opublikowała Zasady dobrej praktyki uczenia maszynowego oraz projekt wytycznych dotyczących funkcji oprogramowania urządzeń wspieranych przez AI (zarządzanie cyklem życia, przejrzystość, ograniczanie uprzedzeń oraz Plany Kontroli Zmian Z góry Określonych dla systemów uczących się). Amerykańska Agencja ds. Żywności i Leków

Implikacja: Chatboty diagnostyczne będą musiały spełniać znacznie bardziej rygorystyczne wymagania dotyczące dowodów i przejrzystości, zanim klinicyści będą mogli na nich polegać w rutynowej opiece. Parlament Europejski

Prognoza: Czego się spodziewać w ciągu najbliższych 12–24 miesięcy

- Od „ogólnego” do „medycznej klasy”: Należy spodziewać się większej liczby LLM dostosowanych do dziedziny (takich jak Med‑PaLM 2, systemy w stylu AMIE), które łączą rozumowanie z wyszukiwaniem zweryfikowanych źródeł medycznych. Wstępne badania sugerują lepsze bezpieczeństwo i akceptację, ale walidacja kliniczna pozostaje wyzwaniem. Nature

- Klinicysta w pętli już na etapie projektowania: Szpitale będą preferować narzędzia, które wspierają, a nie zastępują klinicystów—np. generowanie list różnicowych, cytowanie wytycznych i sygnalizowanie niepewności—ponieważ tego oczekują regulatorzy i organizacje zawodowe. Amerykańskie Stowarzyszenie Medyczne

- Dowody ponad obietnice: Zakupy będą się przesuwać w kierunku mierzalnych rezultatów (skrócenie czasu, poprawa przypominania, mniej sytuacji bliskich błędom) wykazanych w badaniach prospektywnych—nie tylko w testach porównawczych. Narzędzia do syntezy dowodów zapowiadają ten kierunek. Nature

- Wzmacnianie odporności na halucynacje: Dostawcy będą się ścigać, by dodać RAG, skalibrowaną niepewność i linkowanie do źródeł. Badania dokumentujące fałszywe cytowania (w tym w pracy z Mediolanu) sprawiają, że to pilny problem do rozwiązania. PubMed

Co powinieneś zrobić teraz

- Jeśli jesteś klinicystą:

- Używaj AI tylko jako wsparcia; weryfikuj zgodnie z wytycznymi i dokumentacją pacjenta.

- Preferuj narzędzia, które pokazują źródła (z działającymi linkami) i raportują poziom pewności/niepewności.

- Dokumentuj swój nadzór; nie kopiuj i nie wklejaj tekstu AI do dokumentacji bez przeglądu. American Medical Association

- Jeśli jesteś pacjentem:

- Traktuj odpowiedzi chatbota jako edukacyjne—nie jako porady medyczne.

- Przynieś wyniki AI na wizytę i poproś swojego lekarza o potwierdzenie lub korektę. American Medical Association

Uwagi metodologiczne (aby zachować „70%” we właściwej perspektywie)

Badanie mediolańskie oceniało rozumowanie patologiczne w tekście (bez obrazów mikroskopowych), wykorzystując syntetyczne, ale zgodne z wytycznymi scenariusze recenzowane przez specjalistów. Sześciu patologów oceniało odpowiedzi i cytowania. Wskaźnik ~70% odzwierciedla jakikolwiek błąd, a niekoniecznie nieprawidłową ostateczną diagnozę za każdym razem. Ta subtelność wyjaśnia, dlaczego inne badania mogą wykazywać wyższą dokładność w pytaniach wielokrotnego wyboru, a jednocześnie znacznie niższą dokładność dla rozumowania klinicznego w formie otwartej. PubMed

Źródła

Badanie podstawowe i relacje medialne: Virchows Archiv (European Journal of Pathology) abstrakt; ANSA; WirtualneMedia. Kontekst i dowody przeciwne: JAMA Network Open (przypadki onkologiczne), Nature Medicine (Med‑PaLM 2), Nature (AMIE), npj Digital Medicine (TrialMind). Polityka: Komisja Europejska / Parlament Europejski w sprawie AI Act; wytyczne FDA & GMLP. U.S. Food and Drug Administration

Nota redakcyjna: Ten artykuł jest przeznaczony dla szerokiego grona odbiorców i nie stanowi porady medycznej. Zawsze konsultuj się z wykwalifikowanym lekarzem w celu diagnozy i leczenia.